3.1. 激活函数和代价函数

本文最后更新于 2025年6月4日 晚上

逻辑回归、激活函数及其代价函数

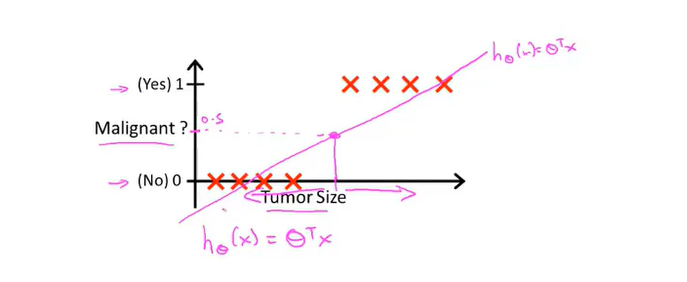

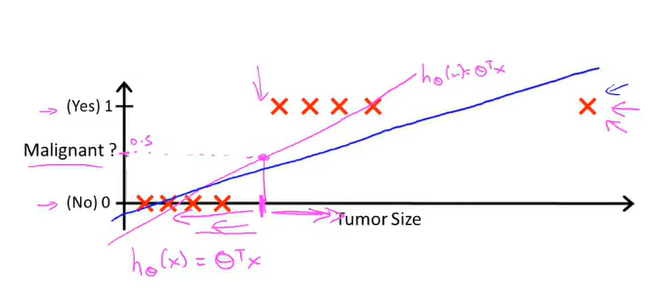

线性回归的可行性

对分类算法,其输出结果y只有两种结果{0,1},分别表示负类和正类,代表没有目标和有目标。

在这种情况下,如果用传统的方法以线性拟合\({h_θ (x)=θ^T X}\),对于得到的函数应当对y设置阈值a,高于a为一类,低于a为一类。

对于分类方法,这种拟合的方式极易受到分散的数据集的影响而导致损失函数的变化,以至于对于特定的损失函数,其阈值的设定十分困难。

除此之外,\({h_θ(x)}\)(在分类算法中称为分类器)的输出值很可能非常大或者非常小,并不与{0,1}完全相符

假设表示

基于上述情况,要使分类器的输出在[0,1]之间,可以采用假设表示的方法。 设\(h_θ (x)=g(θ^T x)\),其中\(g(z)=\frac{1}{(1+e^{−z} )}\), 称为逻辑斯蒂函数(Sigmoid function,又称为sigmoid激活函数,生物学上的S型曲线),有: \[h_θ (x)=\frac{1}{(1+e^{−θ^T X} )}\] 其两条渐近线分别为h(x)=0和h(x)=1

在分类条件下,最终的输出结果是: \[h_θ (x)=P(y=1│x,θ)\] 其代表在给定x的条件下 其y=1的概率 有:

\[P(y=1│x,θ)+P(y=0│x,θ)=1\]

决策边界

对假设函数设定阈值\(h(x)=0.5\),

当\(h(x)≥0.5\) 时,输出结果y=1.

根据假设函数的性质,当 $x≥\(0时,\)h(x)≥0.5$

由于之前用\(θ^T x\)替换x,则当\(θ^T x≥0\)时,\(h(x)≥0.5,y=1\)

解出 \(θ^T x≥0\),其答案将会是一个在每一个\(x_i\)轴上都有的不等式函数。

这个不等式函数将整个空间分成了y=1 和 y=0的两个部分,称之为决策边界(Decision boundary)。

激活函数的代价函数

在线性回归中的代价函数: \[J(θ)=\frac{1}{m}∑_{i=1}^m \frac{1}{2} (h_θ (x^{(i)} )−y^{(i)} )^2 \]

令\(Cost(hθ (x),y)=\frac{1}{2}(h_θ (x^{(i)} )−y^{(i)} )^2\), Cost是一个非凹函数,有许多的局部最小值,不利于使用梯度下降法。对于分类算法,设置其代价函数为:

对其化简: \[Cost(h_θ (x),y)=−ylog(h_θ (x))−((1−y)log(1−h_θ (x)))\] 检验:

当 \(y=1\)时,\(−log(h_θ (x))\)

当 \(y=0\)时,\(−log(1−h_θ (x))\)

那么代价函数可以写成:

\[J(θ)=-\frac{1}{m}[∑_{i=1}^m y^{(i)} log(h_θ(x^{(i)} ))+(1−y^{(i)}) log(1−h_θ (x^{(i)}))]\]

对于代价函数,采用梯度下降算法求θ的最小值,其更新公式为: \[{θ_j≔θ_j−α\frac{∂J(θ)}{∂θ_j}}\]

代入梯度:

\[θ_j≔θ_j−α∑_{i=1}^m(h_θ (x^{(i)} )−y^{(i)} ) x_j^i\]