04.数字图像

本文最后更新于 2025年6月4日 晚上

数字图像

图像是指能在人的视觉系统中产生视觉印象的客观对象,包括自然景物、拍摄到的图片、用数学方法描述的图形。数字图像则是计算机通过离散化处理得到的图像。

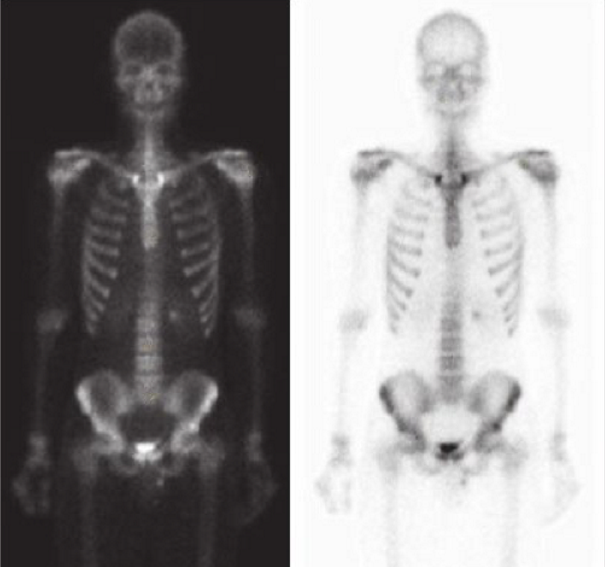

人眼可视的光谱范围内含有的图像信息非常的有限,借助一些数字化设备可以获得超出可视频谱范围的数字图像,例如X光图、核磁共振成像、脑电图、卫星图像、超声图像、显微图、紫外线图等等。这些图像可以帮助人们获取某些裸眼可视之外的信息。

眼球成像机理

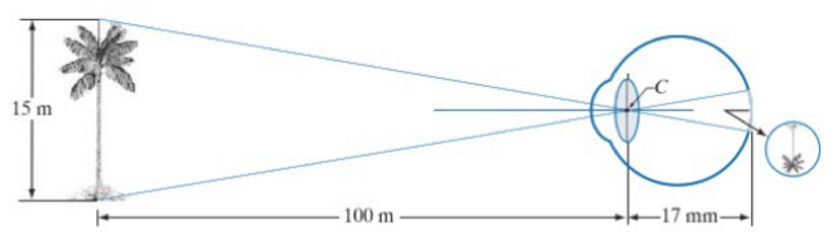

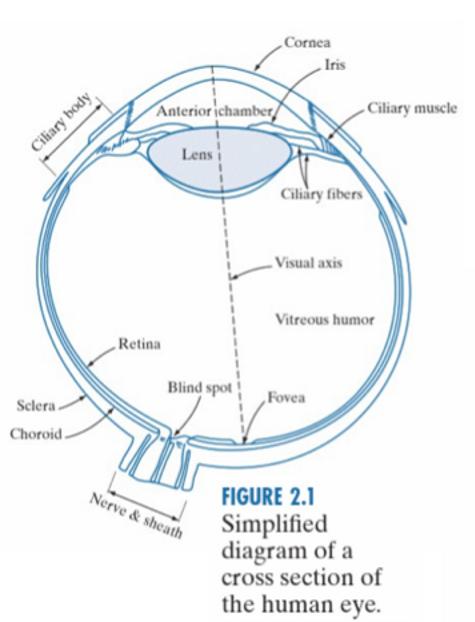

光从空气进入眼睛内,依次通过的屈光介质有泪膜、角膜、房水、晶状体、玻璃体,最后到达视网膜。因为这些屈光介质的折射率不同,所以每由一种介质进入另一种介质,光线都会发生一次折射。这是一个多个折射混合的过程,神奇的是,最后光正好在视网膜的黄斑中心凹聚焦成像。把这一组过程等效成一个光路图,如下图所示:

所有的屈光介质相当于一个大的凸透镜。焦点就是视网膜(Retina)。因为无穷远的光是平行光,要现想在视网膜上聚焦,光路必须偏向光轴。所以眼的屈光系统相当于一个凸透镜。至此,物体是以光信号的形式传递到了视网膜上。接收到了光信号后,视网膜负责将光信号转换成电信号。

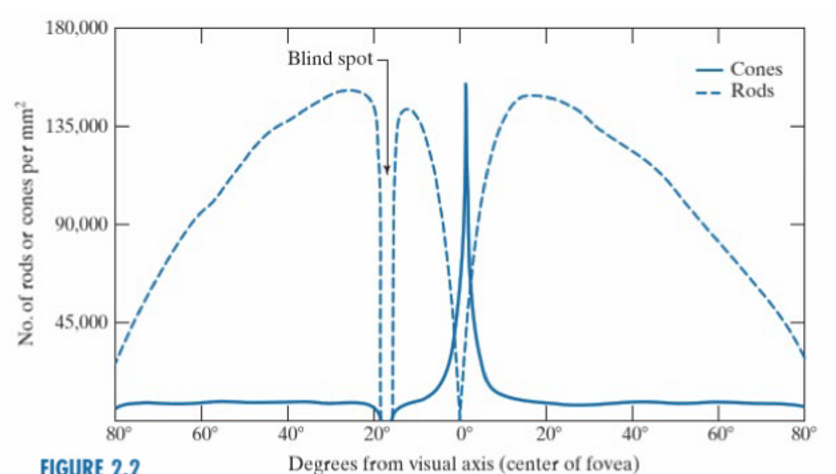

视网膜上分布着两种细胞:对亮度敏感的视锥细胞(Cones)和对暗光敏感的视杆细胞(Rods)。这两种细胞在视网膜上的数量分布如图所示:

光打在视网膜上的视锥细胞和视杆细胞上时,通过视色素的漂白作用,关闭钠离子通道,导致细胞内外的电压的变化。转换成的电信号,通过视神经传递到视觉中枢。

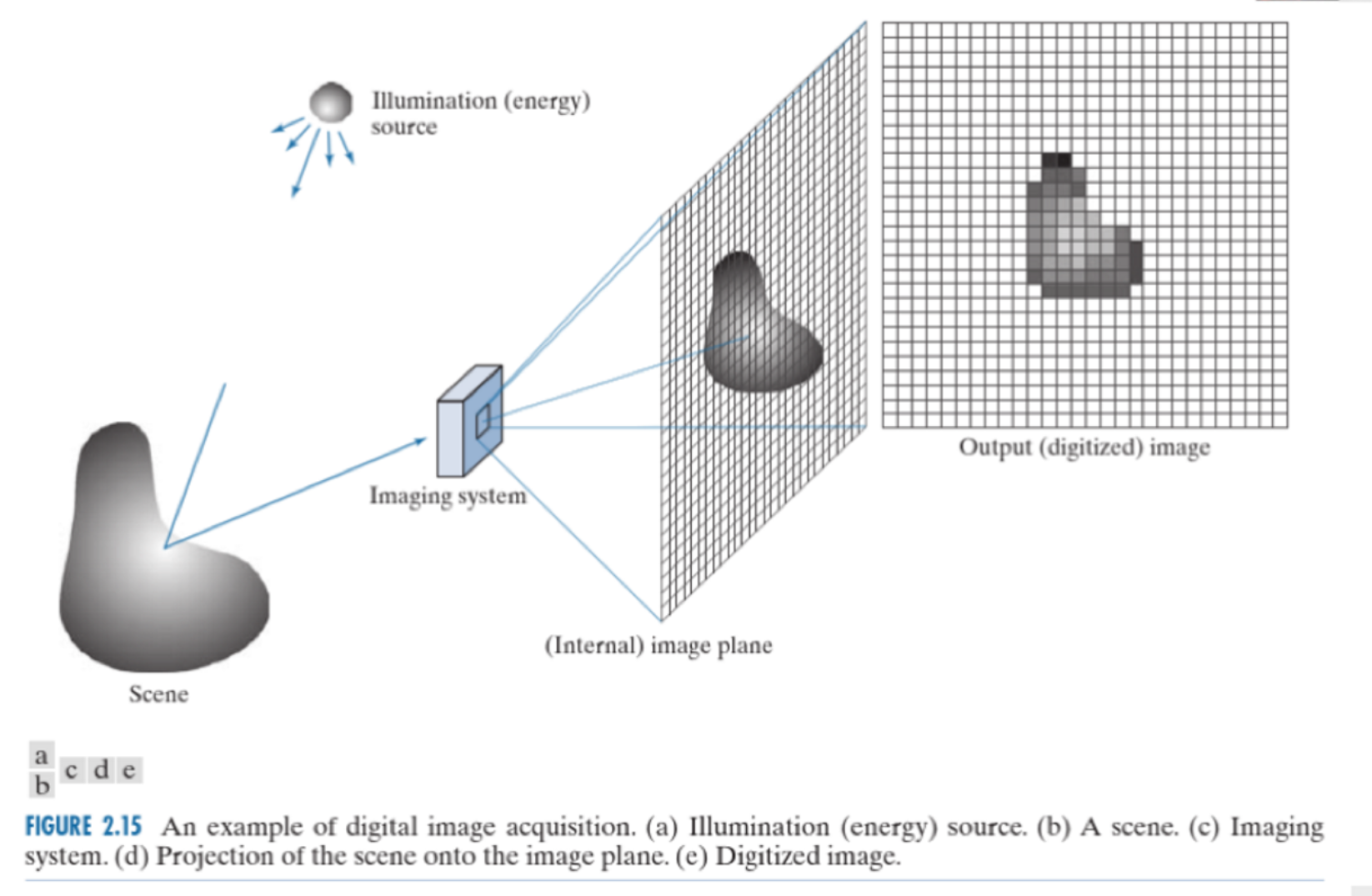

图像的数字化

像人眼一样,相机的镜头充当了屈光介质,而物体的像会投影在相机的CMOS传感器上,类比于人眼的视网膜。如同视网膜上的视锥细胞和视杆细胞一样,CMOS传感器将光学信息分为不同的单元,每个单元只处理一部分光学信息,这样的单元称为像素(pixel)。COMS拥有一个像素阵列(pixel array),当外界光照射像素阵列时,CMOS上对应的像素单元发生光电效应,产生相应的电荷,从而将光信号转换为电信号。行像素单元内的图像信号通过各自所在列的信号总线传输到对应的模拟信号处理单元以及A/D转换器,转换成数字图像信号输出。

离散化过程

离散化(discretization)需要完成对光学信息空间位置的离散化(即对应信息的位置的离散化)和对每一个像素单元中光学信息强度的离散化(即对应信息的强度的离散化)。

和大部分信息的数字化一样,这一过程可以大致分为两步将光学信息转换为数字图像:采样(sampling)和量化(quantization)。采样负责对离散空间信息,量化则是进一步对强度值进行离散化。

灰度值和RGB值

灰度图像

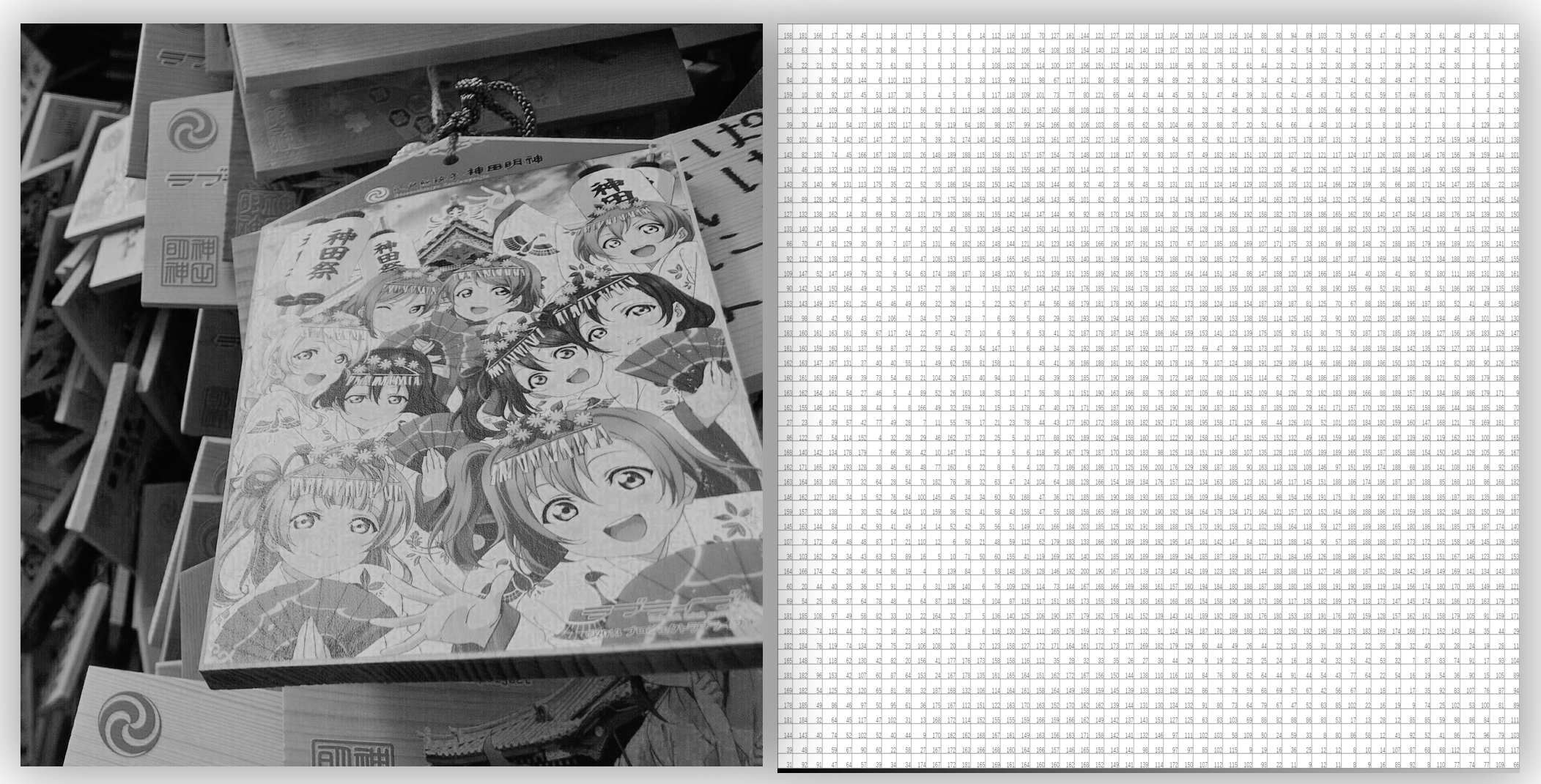

对于黑白图像,或者又称为灰度图像(grey image),光学信息的强度可以被一个值描述,这个值描述了一个像素区域内的信息有多黑/有多白,这个值称为灰度值(gray-scale value)。

通常,在图像处理领域认为灰度值的范围为\([0,255]\),其中0表示纯黑色\(\color{black}{▨}\),255表示纯白色 \(\color{white}{▨}\),用8比特进行表示。

因此,每一张灰度图像都可以用一个矩阵表示,矩阵的每个位置上的元素表示对应空间上图像的像素点的灰度值。

下图展示了一张灰度图和它所对应的灰度值矩阵:

彩色图像

对于彩色图像,则是将图像拆分为由红绿蓝(Red\(\color{red}{▨}\),Green\(\color{green}{▨}\),Blue\(\color{blue}{▨}\) )这三种光学三原色组成的三个图层,每个图层上的像素值依次表示对应颜色的深度,因此彩色图像中的每一个像素都可以由一个三维坐标\((R,G,B)\)进行表示,每个维度的值域均为\([0,255]\),均使用8比特进行表示。例如:▨这种颜色在RGB空间中的坐标表示为:\((102,204,255)\),实际上是R=102▨,G=204▨,和B=255\(\color{blue}{▨}\)这三种颜色的叠加。

因此,每一张彩色图像都可以用三个矩阵表示,矩阵的每个位置上的元素表示对应空间上图像的像素点的R/G/B值。视频

视频是由一张一张的静态图快速播放形成的,一张静态图称为一帧(frame),比如人眼分辨率的下限为每秒24帧,即视频一秒钟包含24张静态图,如此人眼才会将这些播放的静态图视为“动态的”。因此,每秒24帧的彩色视频中包含24张彩色图。

因此每一个视频都可以转化为若干的矩阵时序序列。

量化过程涉及的术语

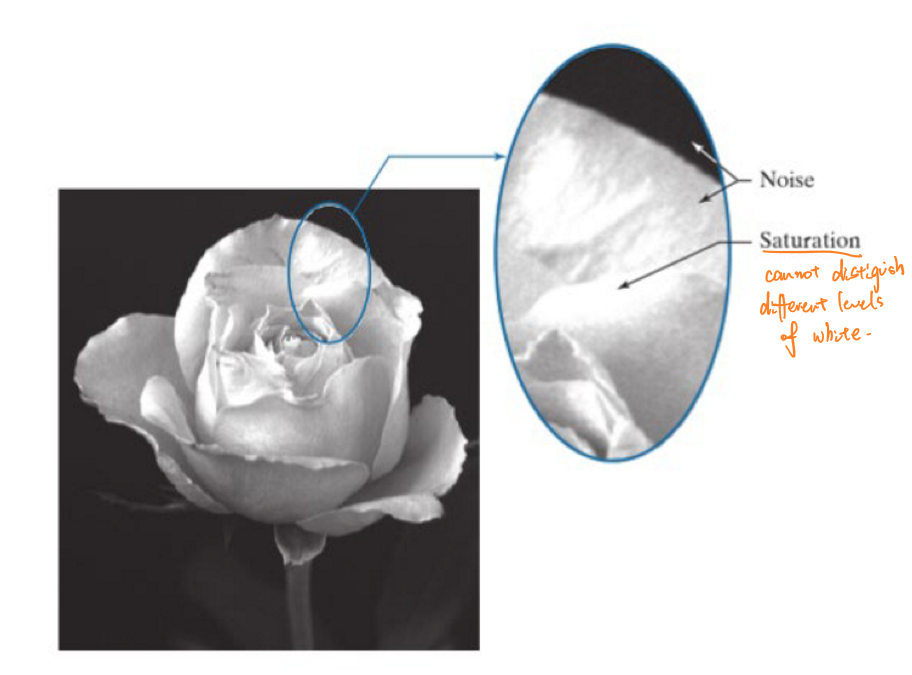

饱和(satuation)

饱和是指量化过程中相似的模拟信号被量化为同一个数字而造成的细节丢失。

空间分辨率(spatial resolution)

空间分辨率是指解析传感器区分紧密间隔物体的能力,代表了使用多少个像素来表达一幅图像。空间分辨率的大小表明了影像细节的可见程度。

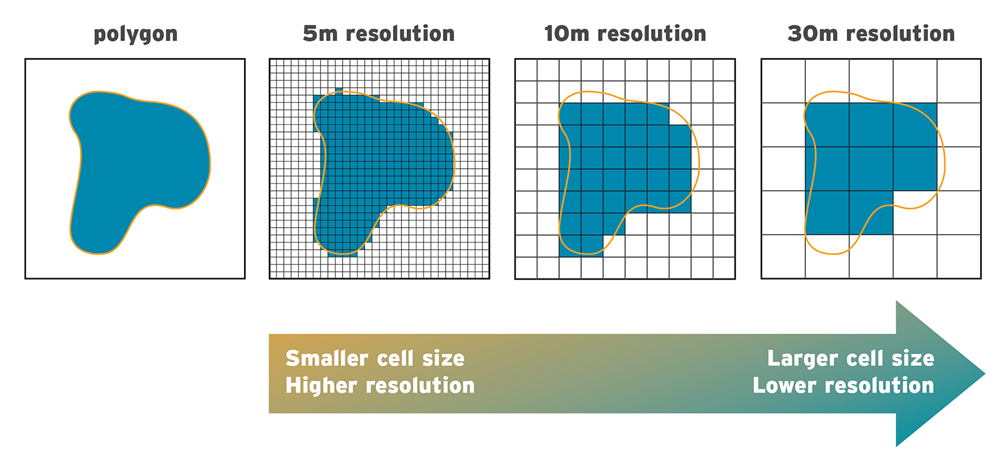

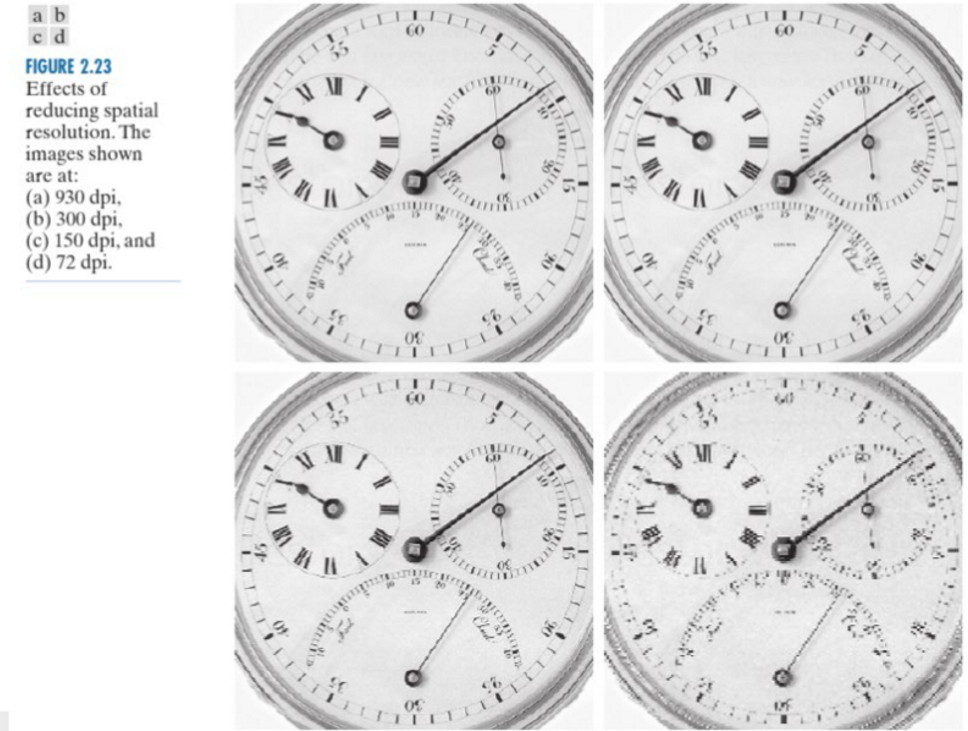

下图展示了使用不同空间分辨率对同一个模拟图像进行量化后的结果。

可以发现,空间分辨率越高,其识别物体的能力越强,图像的细节越丰富。灰度分辨率(grey level resolution)

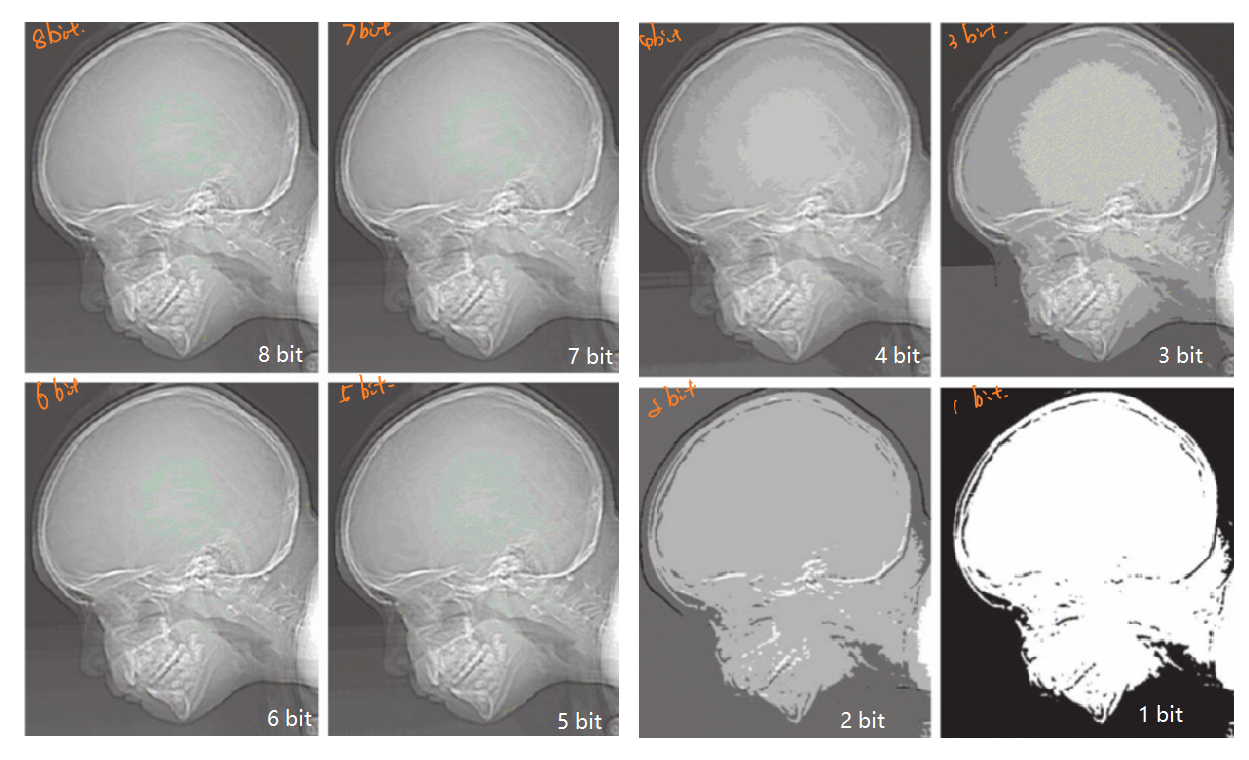

灰度分辨率是灰度级中可分辨的最小变化,代表了使用多少个比特来表示从纯白到纯黑的灰度范围。通常,灰度级是2的整数次幂,常用的是8bit.

下图展示了使用不同灰度分辨率对同一个模拟图像进行量化后的结果。

可以发现,灰度分辨率越高,其识别物体的能力越强,图像的明暗层次越丰富。

基础图像处理

通过前文可知,图像处理的本质是对图像所对应的矩阵进行相关的数学操作。

基础的图像处理有叠加、差分、反转、平移、旋转和缩放。

叠加

叠加对应的矩阵操作就是将两个图片所对应的矩阵(以灰度图为例,下同)\(I_1,I_2\)进行相加:

\[I_1+I_2\] 相加后的效果为“亮的更亮、暗的更暗”,图像对应的像素会比原来的像素值更高。

将多张拍摄场景相同,但是随机噪点的数量和位置不同的照片通过叠加,可以得到比原来任何一张图片都噪点都要小很多的照片。

叠加的原理被广泛应用在智能手机的低光拍摄中:在夜景或者暗光环境下,相机在按快门到成像的时候会用不同参数采集多张/多帧照片或者影像,在不同的帧数下找到不同的带有噪点性质的像素点,通过加权合成后得到一张较为干净、纯净的夜景或者暗光照片。由相机中的智能系统将有噪点的地方用没有噪点的帧数替换位置,经过反复加权、替换,就得到一张清晰的照片。

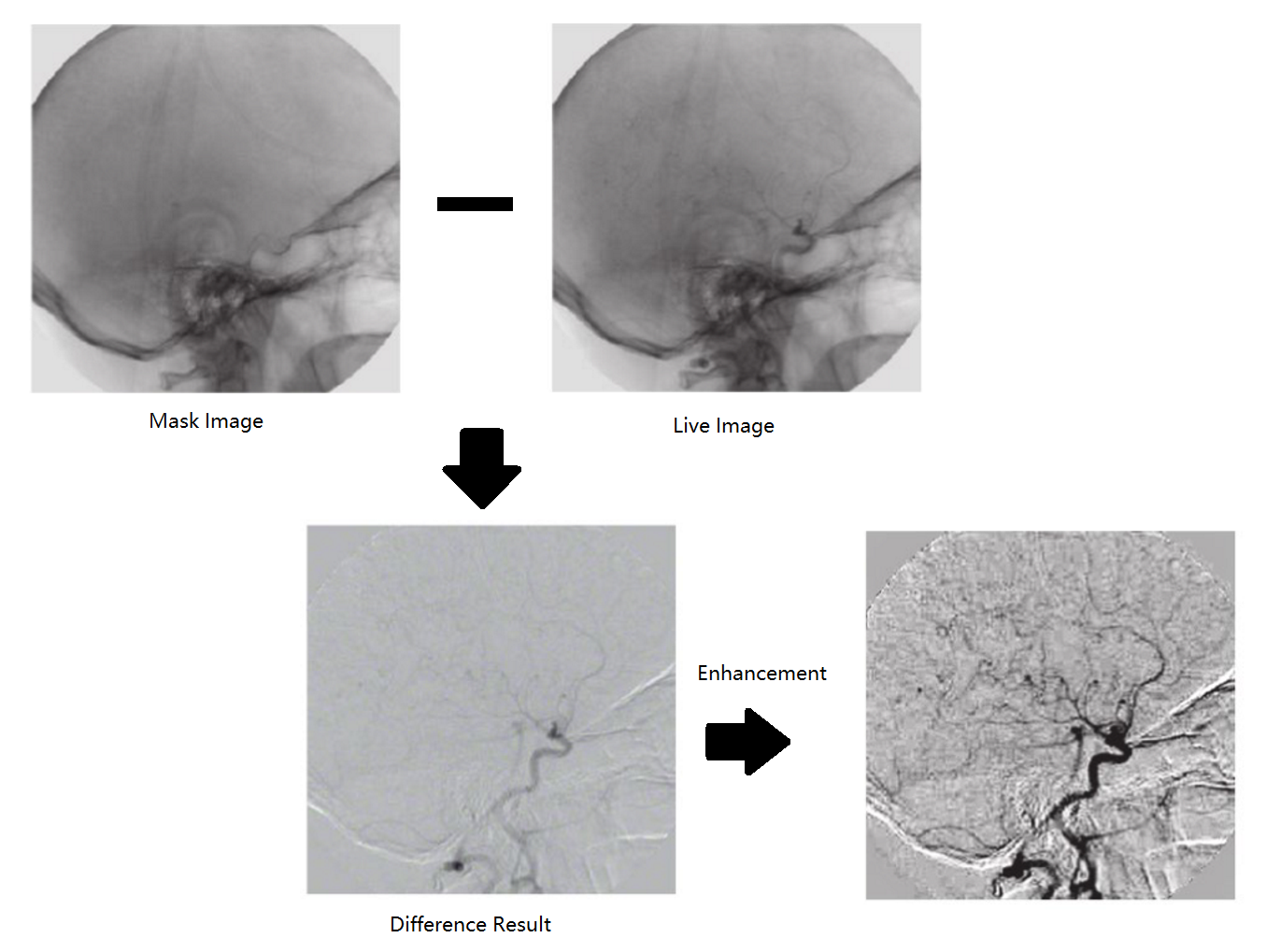

差分

图像差分,就是把两幅图像的对应像素值相减,以削弱图像的相似部分,突出显示图像的变化部分。

\[I_1-I_2\] 差分可以用于异常检测中:使用一张正常状态的图片与需要进行异常检测的图片进行差分,可以发现被检测图片中与标准图片不一致的地方。

反转

对图像反转对应的是量化级的最高值减去图像当前对应的像素值,对于8bit灰度图,反转表示为一个全为255的矩阵减去图像对应的矩阵:

\[[255]-I_1\]

平移、旋转和缩放

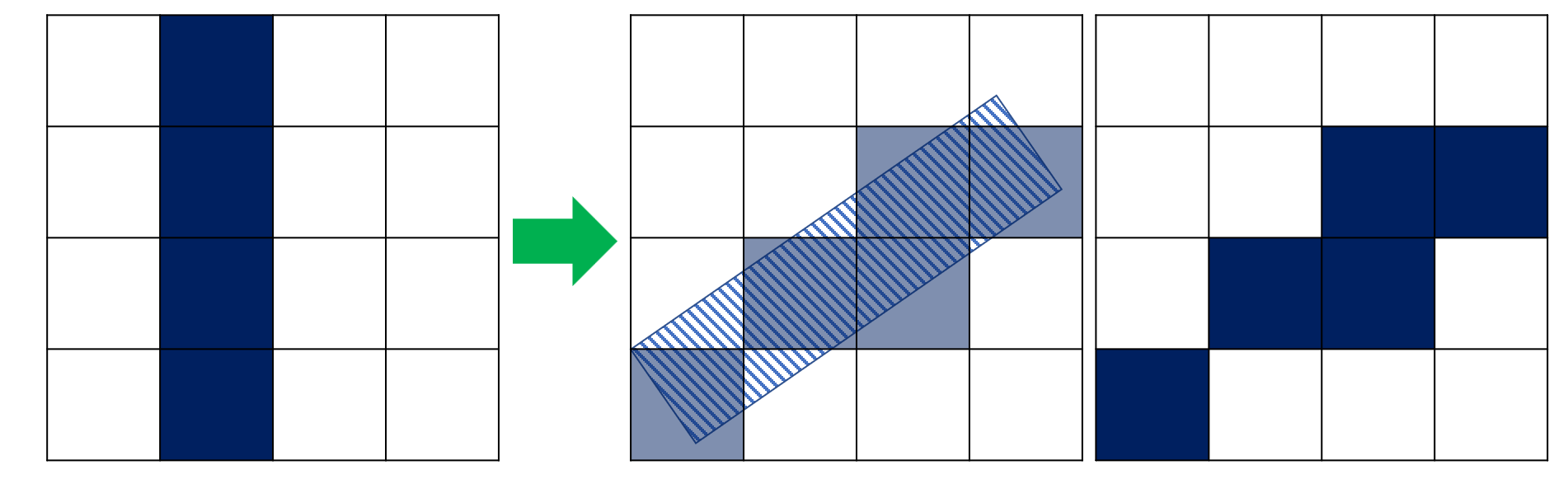

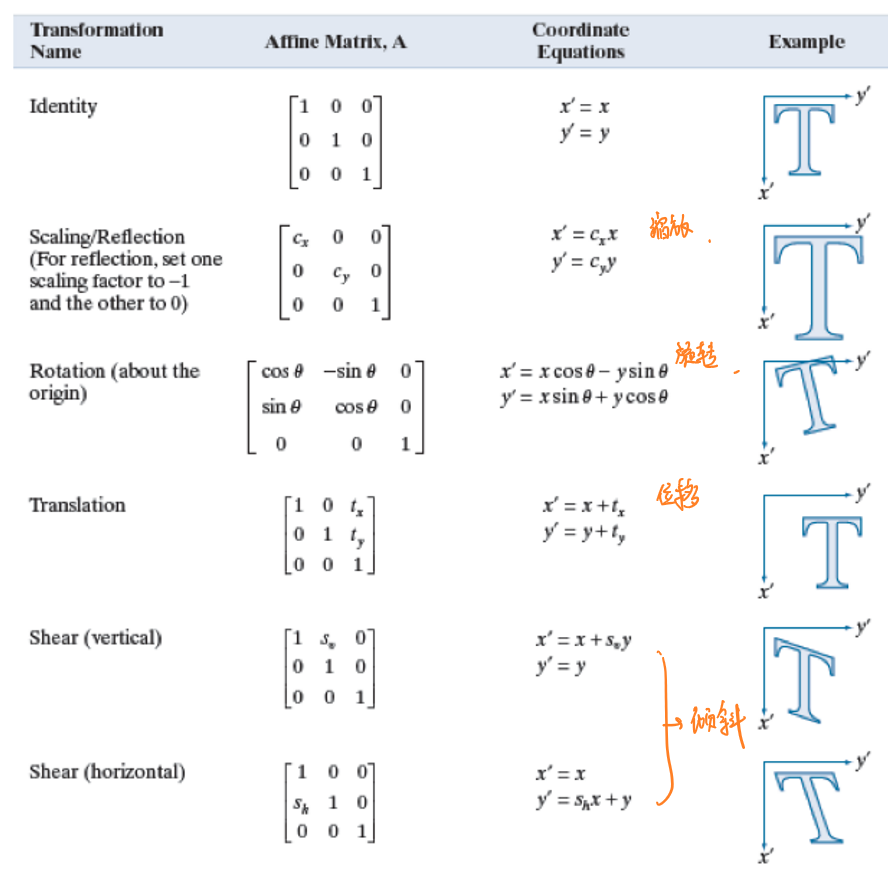

图像的平移、旋转和缩放则是将原图像与一个对应的矩阵相乘,如下图所示:

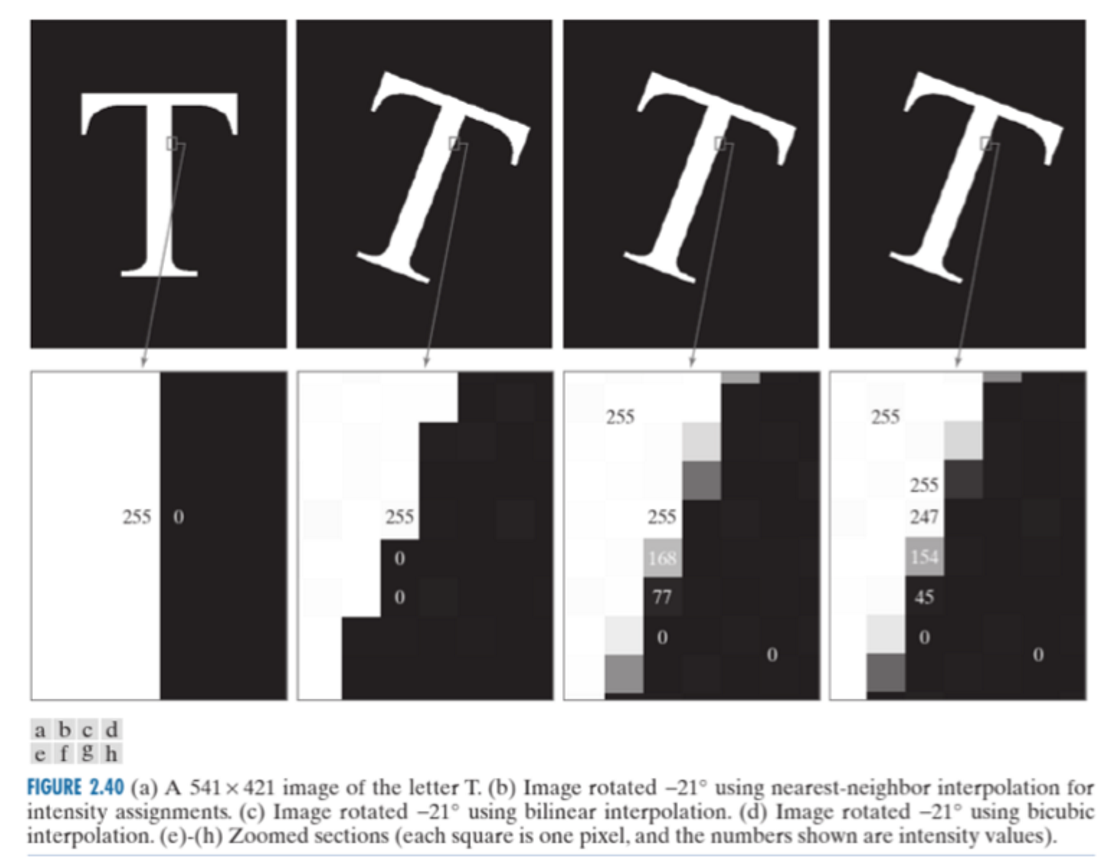

需要注意的是,对于图像的旋转操作会由于图像空间量化误差而造成信息上的损失,如下图所示,某个图像经过旋转后出现了信息丢失,这是因为在空间量化中只认为图形在每个像素中占比超过50%的部分才会有对应的像素值: